"Все, що ми спостерігаємо і чуємо, може виявитися ілюзією," -- Олена Чуранова в подкасті "Медіуми".

У випуску -- про методи й інструменти викриття фейків, що створені штучним інтелектом.

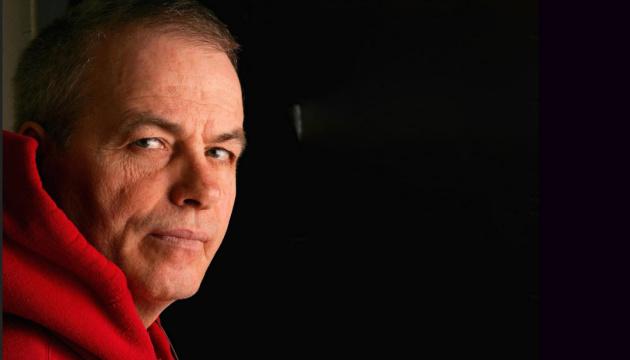

Штучний інтелект дедалі більше інтегрується в наше повсякденне існування, ставши не тільки корисним інструментом, а й засобом для поширення дезінформації. Чому такі вигадані персонажі, як "брати-близнюки", "щасливі пари" чи "сумні солдати", які просять про вітання, набувають вірусної популярності? Як діють алгоритми платформ, таких як Facebook і TikTok, що сприяють розповсюдженню фейкових новин? І найважливіше — які методи можна застосувати, щоб уникнути пасток інформаційних маніпуляцій? На ці питання відповіли ведучі подкасту "Медіуми" Наталя Соколенко та Вадим Міський в розмові з Оленою Чурановою, редакторкою та фактчекеркою проєкту StopFake.org.

Ви можете підписатися на подкаст "Медіуми" через різні платформи, такі як Apple Podcasts, Spotify, SoundCloud, Megogo Audio, NV Подкасти, YouTube Music, YouTube та інші ресурси для прослуховування подкастів.

00:00 "На жаль, люди все ще віддають перевагу вітанням вигаданим персонажам."

03:48 Соціальні мережі — це не просто платформи, це бізнес-структури. А ми в їхньому контексті виступаємо як товар.;

04:47 "Інструменти штучного інтелекту наразі не досягли рівня, на якому підробки можуть виглядати абсолютно правдоподібно."

08:42 "Колись, коли ти спостерігав щось на власні очі, це вважалося беззаперечною істиною. Сьогодні ж ми не можемо стверджувати того ж самого.";

11:20 Необхідно бути готовими до того, що все, що ми спостерігаємо та чуємо, може виявитися імітацією.;

12:26 "70% українців черпають інформацію з Telegram. Це може бути ризиковано."

14:07 Зловмисники застосовують штучний інтелект для виготовлення фальшивих зображень, на яких нібито українцям надають гуманітарну допомогу.;

19:10 "Ці інструменти легко освоїти, але ми стикаємося з непростими завданнями.".

"Люди, на жаль, усе одно вітають вигаданих осіб"

Вадим Міський: Сьогодні ми розглянемо тему штучного інтелекту, зокрема, як він може бути використаний для генерації дезінформації та які цілі можуть стояти за цими діями, адже мотивація може бути дуже різною. Також ми зупинимося на практичних інструментах для виявлення контенту – зображень, відео чи текстів, створених за допомогою штучного інтелекту. Хочу розпочати з того, що, переглядаючи стрічку у Facebook, я помічаю, що майже кожен п'ятий пост містить фото з такими підписами: "Ці три брати служать в одному підрозділі, пішли на війну. Сьогодні у них день народження. Брати, звісно, близнюки". Або ж: "Ця пара сьогодні одружилася, і жодна "собака" їх не привітала".

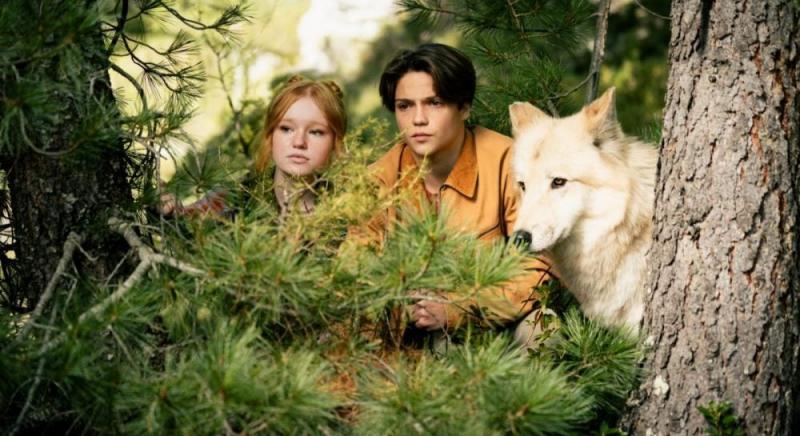

Ілюстрації, генеровані штучним інтелектом. Колекція постів для Facebook.

Що це за "пари" та "брати", які безперервно з'являються, святкують свої дні народження та укладають шлюби? Чому про них згадують на якихось сторінках, а не вони самі діляться своїми новинами і запрошують нас їх вітати? Чи отримують наші привітання ці люди?

Наталя Соколенко: Я помітила, що всі вони надзвичайно привабливі, просто чарівно красиві.

Олена Чуранова: Власне, вони всі такі ідеальні, тому що їх насправді не існує. Ці зображення згенеровані штучним інтелектом. Є навіть такий сайт -- thispersondoesnotexist, на який ви можете зайти. Щоразу, коли ви клацатимете, там з'являтиметься нова людина, згенерована цим інструментом. Цей сайт існує вже три-чотири роки, і я розповідаю про нього на тренінгах. Але, власне, два роки тому з'явився генеративний штучний інтелект, який став доступним для всіх. І тепер він розв'язав руки творцям цих "близнюків", "собак", "підрозділів" тощо.

Цей інструмент почали використовувати навіть ті, хто займається навмисним розповсюдженням дезінформації, а також інші особи, які прагнуть на цьому заробити. Найбільша загроза для нас полягає в тому, що в країні триває війна, і інформаційний аспект є вкрай важливим. Наприклад, штучний інтелект застосовується для підвищення популярності певних груп. Люди, на жаль, часто підтримують цих вигаданих персонажів. Не зовсім зрозуміло, чому так трапляється, але вони залишають коментарі, ставлять лайки або виражають своє обурення. І навіть якщо їхні реакції негативні, вже з'явилися різноманітні меми на цю тему, наприклад: "У вас немає розуму, якщо ви повірили в згенероване ШІ-зображення". Це свідчить про те, що контент уже існує, але люди все ще реагують. А коли вони реагують — лайкають або обурюються — це стає сигналом для соціальних мереж, що публікація користується популярністю, і її слід підвищити в стрічці.

Соціальні мережі — це не просто платформи, це бізнес-структури. А ми в їхньому контексті виступаємо як товар.

Наталя Соколенко: А чому соцмережі такі тупі? Чому їхні менеджери не використовують відповідні фільтри, щоб відсіювати зображення, згенеровані штучним інтелектом? Якщо ми говоримо про Тікток, то він одного поля ягода, а от Фейсбук...

Олена Чуранова: Вони не є недалекоглядними. Це бізнес-структури. А ми для них – ресурс: наша увага та час, витрачений у стрічці новин. Тому, навпаки, коли щось набирає популярності, щось привертає нашу увагу – вони це підтримують. Наразі Facebook та, зокрема, Instagram впровадили функцію, яка дозволяє позначати публікації, створені штучним інтелектом. Ми, як партнери програми перевірки фактів, можемо вказувати на фальшиві новини, згенеровані ШІ, і соціальні мережі реагують на це. Проте, незважаючи на всі ці ініціативи, ніхто не зможе заборонити вам публікувати щось незвичайне. Якщо така публікація викликає багато реакцій, вона продовжить поширюватися.

"Інструменти штучного інтелекту поки що не мають достатнього рівня розвитку, щоб створити підробки, які виглядають цілком реалістично."

Наталя Соколенко: Тож давайте перейдемо до інструментів. Які ресурси використовує StopFake? Які інструменти можуть бути корисними для звичайного журналіста, який не має спеціалізації в галузі фактчекінгу?

Олена Чуранова: Насправді, всі засоби, які допомагають виявляти контент, створений штучним інтелектом, досить прості у використанні як для журналістів, так і для звичайних користувачів. Принцип їх роботи полягає в тому, що ви завантажуєте зображення, відео або текст, а інструмент аналізує ймовірність того, що цей контент був згенерований ШІ. Наприклад, для фотографій та відео ми часто користуємося такими інструментами, як AI or Not або DeepFake-o-meter, які допомагають виявити дипфейки. Проте важливо розуміти, що ці інструменти не є єдиним способом визначення фальшивок. Сьогодні люди можуть досить легко розпізнавати як дипфейки, так і "близнюків", а також штучно створені зображення. Технології штучного інтелекту ще не досягли такого рівня, щоб підробки виглядали абсолютно правдоподібно. На всіх тренінгах учасники, уважно вивчаючи деталі, здатні чітко визначити, де є підробка. Загалом, це не є складним завданням: достатньо звернути увагу на руки та пальці, адже їхнє генерування досі має недоліки — часто з'являється шість або сім пальців.

Наталя Соколенко: Головне -- вмикати мізки, а вже потім шукати інструменти. Але якщо говорити про ці інструменти -- вони всі платні?

Олена Чуранова: Більшість із цих інструментів, звісно, є платними, але деякі з них надають можливість безкоштовної перевірки контенту. Наприклад, DeepFake-o-meter, розроблений Університетом Баффало, доступний безкоштовно. Окрім таких спеціалізованих рішень, існують й інші методи верифікації. Одним із них є розширення InVID, яке можна інтегрувати в Google Chrome. Це розширення допомагає аналізувати відео та зображення. Наприклад, ми стикалися з дипфейком, в якому Валерій Залужний нібито заявляв про намір здійснити державний переворот та вести війська на Київ. Хоча цей дипфейк виглядав досить переконливо, нам вдалося його викрити. Його було важче ідентифікувати, ніж відомий дипфейк із Володимиром Зеленським, який викликав багато жартів на початку вторгнення.

Дипфейк із Володимиром Зеленським (березень 2022 року) та дипфейк із Валерієм Залужним (листопад 2023 року)

У даному випадку ми намагалися знайти автентичне відео, яке зазнало модифікацій. Тут на допомогу прийшов інструмент InVID: ми завантажили відео в цю програму, яка розбила його на окремі кадри. Потім ці кадри були перевірені за допомогою різних пошукових систем, таких як Google і "Яндекс". Останній ми використовуємо, адже він має величезну базу даних зображень, включаючи матеріали з російськими військовими. Під час пошуку за зображеннями нам вдалося знайти первісний кадр: це було відео, яке знято на початку вторгнення, коли Залужний коментував війну. Його просто взяли і сфальсифікували. Цей процес допоміг підтвердити, що відео є підробленим.

"Колись, коли ти спостерігав щось на власні очі, це вважалося беззаперечною істиною. Сьогодні ж ми не можемо стверджувати того ж самого."

Вадим Міський: Я б хотів підкреслити ще один важливий момент, пов'язаний із розповсюдженням фальшивих матеріалів, створених за допомогою штучного інтелекту, — це контент, що здатний викликати яскраві емоційні реакції.

Отже, якщо людині в спокійній обстановці продемонструють зображення і попросять уважно його проаналізувати, вона може задуматися, чи не є воно творінням штучного інтелекту. Проте насправді цей контент подається зовсім інакше. Нам розповідають історію про "кількох братів" або "пару", супроводжуючи це емоційним відео. Наприклад, раніше циркулювало відео, де нібито зображено українського солдата з синдромом Дауна, який, за словами авторів, зазнає знущань від своїх товаришів по службі. Згодом з'ясувалося, що це результат роботи штучного інтелекту. Хоча технологія була досить простою — у кадрі з'явилася реальна людина, але її зовнішність була модифікована за допомогою нейромережі. Це нагадує маски в Instagram, які багато з нас бачили й використовували.

Дипфейк із нібито "солдатом із синдромом Дауна"

Що ж робити, коли стикаєшся з таким емоційним контентом? Як повернути себе до реальності? Як відрізнити штучний інтелект, якщо він намагається проникнути крізь наш захист критичного мислення?

Олена Чуранова: Перш за все, потрібно усвідомити, що ми знаходимося в іншій реальності. Раніше, коли ти бачив щось на власні очі, це вважалося правдою. На жаль, сьогодні ця істина вже не є такою однозначною.

Нещодавно вийшов фільм під назвою "Смерть Путіна", який повністю створений за допомогою штучного інтелекту. У ньому актор носить маску, щоб нагадувати президента Путіна, і в сценах показано його смерть. Такі технології вже стали звичними — і нам потрібно бути до них готовими. Дітям важливо навчитися критично оцінювати інформацію, адже вони активно користуються TikTok та іншими соціальними мережами, де постійно натрапляють на відео. Вони повинні усвідомлювати, що все, що вони бачать на екрані, може бути фальсифікацією.

Якщо взяти до уваги відео, яке нібито демонструє знущання в армійських умовах, важливо провести первинну перевірку: звідки походить ця інформація? Хто є її першим джерелом? Чому вона з’явилася в моїй стрічці новин? Іншими словами, необхідно виявити першоджерело. Безумовно, це завдання журналістів, але сьогодні воно стосується кожного з нас. Виробити та поширити дезінформацію надзвичайно легко, так само як і викликати емоції, які спонукають нас миттєво ділитися цією інформацією.

Необхідно бути готовими до того, що все, що ми спостерігаємо та чуємо, може виявитися імітацією.

Наталя Соколенко: Чи є якісь прогнози, куди нас може занести ця історія з контентом, створеним за допомогою ШІ? Чи може настати момент, коли ми прокинемося, а навколо буде суцільний дипфейк?

Олена Чуранова: Звісно, хотілося б залишатися оптимісткою, але ситуація, коли нібито мер Києва зв’язався з мером Мадрида та Берліна, справила на мене глибоке враження. Вони повірили в цю розмову і деякий час спілкувалися з особою, котра видавала себе за Віталія Кличка, хоча це насправді був фейк. Відео, яке стало основою для цього інциденту, було створено за допомогою штучного інтелекту з синтезованим голосом. Лише коли цей "Кличко" почав висловлювати думки про те, що Україні не слід допомагати, їхнє занепокоєння зросло. Цей випадок яскраво ілюструє потенційні загрози майбутнього, адже тепер можна підробити практично все: будь-який телефонний дзвінок, команди керівника, відеозвернення президента та інше. Необхідно бути готовими до того, що, на жаль, усе, що ми чуємо і бачимо, може виявитися підробкою.

"70% українців отримують новини з телеграму. Це небезпечно"

Наталя Соколенко: А чи може статися так, що надійний, перевірений контент зрештою стане повністю платним? Мені проводиться така аналогія: є підробки під відомі бренди. Наприклад, справжня сумка Louis Vuitton може коштувати умовно 10 000 доларів, а підробка -- 300. Чи не може вийти так, що споживання перевіреної, достовірної інформації стане привілеєм лише для заможних людей?

Олена Чуранова: Можливо, так уже і є. Ми бачимо, що якісний контент коштує грошей. Закордонні медіа практично всі мають систему paywall (доступ до матеріалів за передплатою -- "ДМ") і це абсолютно нормально. За якісні книжки, фільми, перевірку інформації -- платять. Але ми маємо розуміти, чому більшість людей користується соцмережами. Тому що вони безплатні. Насправді є багато країн, де люди навіть не користуються гуглом, для них фейсбук чи телеграм і є цим гуглом. Тобто соцмережі -- це головне джерело інформації. І ми, на жаль, бачимо таку ж тенденцію в Україні: 70% українців отримують новини з телеграму. Це насправді небезпечно. Якщо весь якісний контент стане платним, ми лише ширше відчинимо двері для потоку дезінформації. А її стане ще більше. Ми вже бачимо ці тенденції: рік Ілона Маска у твіттері -- і що сталося з платформою? Фейсбук -- що буде далі? Поки що картина, на жаль, не надто оптимістична.

Зловмисники застосовують штучний інтелект для виготовлення фальшивих зображень, на яких нібито українцям надають гуманітарну допомогу.

Вадим Міський: Чи збільшилася ваша робота через появу штучного інтелекту? Як часто ви в своїй діяльності стикаєтеся не лише з дезінформацією, що розповсюджується в Інтернеті, а й з інформацією, яку вам спеціально надсилають для спростування?

Олена Чуранова: Безумовно, обсяг роботи значно зріс, оскільки фейкові матеріали виникають дуже швидко. Проте ми не можемо постійно витрачати наші ресурси на спростування кожного з цих підроблених привітань чи вигаданих історій про "собачок". У цій ситуації легше навчати людей розпізнавати такі дезінформації та аналізувати фотографії. Ще серйознішою проблемою є фальшиві оголошення про фінансову допомогу. Це вже вважається фішингом і шахрайством. Згідно з даними поліції, громадяни втрачають десятки тисяч гривень, намагаючись отримати нібито "швидку фінансову допомогу" від "ООН" або "Червоного Хреста". Зловмисники використовують штучний інтелект для створення підроблених зображень, на яких нібито українцям роздають павербанки чи іншу гуманітарну допомогу. Ми вже підготували інструкцію для виявлення таких фейків і намагаємося, поки це можливо, позначати та видаляти ці шахрайські оголошення. Таким чином, обсяг роботи справді зріс. Але в деяких аспектах штучний інтелект, навпаки, спростив наші процеси.

Наталя Соколенко: У чому ж справа?

Олена Чуранова: Наприклад, я натрапила на цитату Марка Рютте, яка ширилася в російських ЗМІ. Вона звучить так: якщо країни НАТО не збільшать фінансування оборонної промисловості, то всім нам доведеться або вивчати російську, або шукати притулок у Новій Зеландії. Цікаво, що ще в 2019 році Рютте висловлював подібні думки, стверджуючи, що вивчення мови може бути корисним для безпеки та майбутнього. Але коли я побачила цю цитату, у мене виникли сумніви щодо її справжності. Виявляється, російські медіа також стверджували, що "Росія суттєво наростила свою промисловість і виробляє більше, ніж багато країн НАТО". Я вирішила перевірити цю інформацію. Раніше, без сучасних технологій, мені доводилося витрачати години на пошуки промови, вислуховуючи її в очікуванні потрібної цитати. Сьогодні ж на це йде всього п'ять хвилин.

Наталя Соколенко: Які засоби ви використовували? Поділіться, будь ласка, деталями вашої роботи!

Олена Чуранова: Є такий інструмент, як Gloc -- його можна встановити як розширення в Google Chrome. Також, наприклад, є Pinpoint. Ви завантажуєте ютуб-відео, і він автоматично транскрибує весь текст цього відео. Потім ви вже шукаєте потрібну інформацію за допомогою Ctrl+F.

Gloc функціонує по-іншому: він з'являється у вашому YouTube поряд з відео. Вам потрібно лише натиснути на іконку, схожу на ChatGPT, і ви автоматично потрапляєте в ChatGPT, де відео перетворюється на текст. Більше того, система генерує підсумок в десяти пунктах, акцентуючи увагу на найважливішому з висловленого. І все це виконується з неймовірною швидкістю.

Також є інші методи, наприклад, Gemini -- ще один чат-бот. Він чудово працює з ютубом: можна просто запитати, наприклад, "мені потрібна ось ця цитата" -- і він її знайде. Тобто є різні способи, але всі вони значно пришвидшують пошук. Так ось, я перетворила це відео на текст і знайшла підтвердження: Рютте дійсно це сказав.

Наталя Соколенко: Знаєте, я часто слухаю подкасти. Наприклад, я не розумію норвезьку мову, але за допомогою одного з цих інструментів перетворюю аудіо на текст і потім читаю.

Олена Чуранова: Абсолютно! Наприклад, нещодавно був фейк про Польщу. У Польщі дійсно зараз бум трансплантації органів -- у них було дуже багато донорів у 2024 році. А російська пропаганда подала це так, ніби вони використовують органи українських військових. Але ми можемо просто перевірити інформацію: дивимося матеріали в польських медіа, швидко перекладаємо їх за допомогою цих інструментів -- і одразу стає зрозуміло, в чому справа насправді.

"Ці інструменти легко освоїти, але ми стикаємося з непростими завданнями."

Наталя Соколенко: Чи пропонує StopFake якісь навчальні програми — як у форматі офлайн, так і онлайн — для журналістів, редакторів або фахівців з медіа й комунікацій, щоб вони могли ефективно використовувати ці інструменти?

Олена Чуранова: У нас немає постійних курсів, але ми відкриті для запрошень і можемо провести тренінг для всіх бажаючих. Протягом року ми плануємо оновити розділ "Інструменти" на нашому сайті. Наша ініціатива з'явилася 10 років тому, і ми стали піонерами у написанні матеріалів, що допомагають спростовувати різноманітні фейки. Тепер ми оновимо цей розділ, поділимось нашим досвідом та надамо інформацію про різні інструменти. Інструкції будуть максимально простими, тому закликаю журналістів та широку аудиторію ознайомитись з ними. Всі ці інструменти легко використовувати, але ми стикаємось з серйозними викликами, до яких потрібно бути готовими.

В попередніх епізодах подкасту "Медіуми" ми обговорювали з Оленою Тараненко, яким чином уберегтися від медіатравми. Андрій Пилипенко розповідав про основні теми, з яких російська пропаганда здійснювала маніпуляції. Оксана Полулях піднімала питання впливу штучного інтелекту на формування нової реальності, тоді як Катерина Городнича акцентувала увагу на тому, як клікбейт перетворився на бізнес у міжнародному медіапейзаже. Павло Бєлоусов пояснював, чому медіаграмотність неможлива без основ цифрової грамотності, а Оксана Волошенюк ділилася досвідом українських школярів у навчанні критичному мисленню. Денис Зеленов розглядав взаємодію соціальних мереж "24 каналу" та штучного інтелекту. Марина Кафтан підкреслювала важливість критичного мислення як основного засобу протистояння інформаційним атакам. Лідія Смола говорила про те, як алгоритми соціальних платформ сприяють емоційним рішенням, роблячи нас вразливими до маніпуляцій. Ольга Кравченко розповіла про конференцію "Стійкі разом: розвиток медіаграмотності в Україні". Дмитро Литвин розглядав питання "Укрінформу", "УП", телемарафону та "офреки" для журналістів. Крістіна Гаврилюк з Мінцифри обговорила потенціал змін, які можуть принести DMA і DSA на європейському ринку цифрових послуг. Олександр Педан розповідав про співпрацю з Суспільним, новий проєкт замість "УніверCheck" та інші ініціативи Pedan buro. Катерина Котвіцька з Megogo Audio проаналізувала поточну ситуацію та тренди у дистрибуції аудіоконтенту онлайн, а Гала Котова з Viber поділилася, як пандемічний досвід допоміг команді Rakuten Viber розвиватися після початку широкомасштабного вторгнення.

The podcast "Mediums" was recorded by Detector Media as part of a project in partnership with UNESCO and with the support of Japan. The authors are responsible for the selection and presentation of the facts contained in this publication. The views expressed are solely those of the authors and do not necessarily reflect the position of UNESCO or Japan.

Інші публікації

Популярное

В тренде