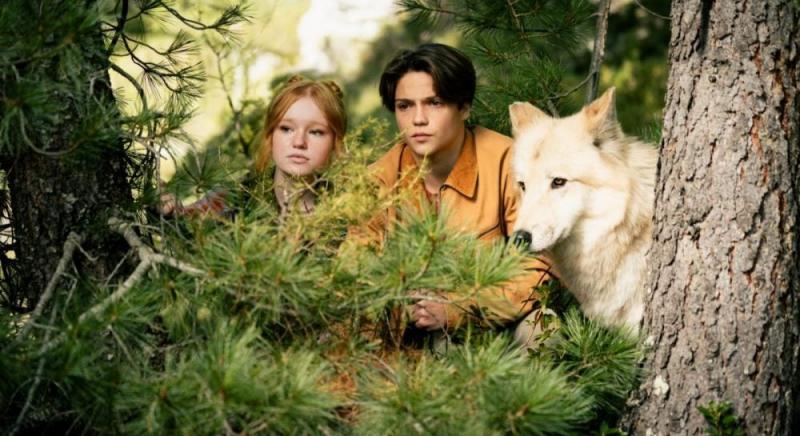

Технології штучного інтелекту продовжують еволюціонувати. "Виявити зображення, створені штучним шляхом, стає все більш складним завданням", -- зазначила Оксана Полулях в епізоді подкасту "Медіуми".

У цьому випуску ми обговоримо, як штучний інтелект формує нову реальність, що вражає своїми здобутками, але також викликає занепокоєння через можливі ризики.

Чому штучний інтелект перетворився на універсальний інструмент для освіти, професійної діяльності, творчості та розваг, водночас відкриваючи можливості для маніпуляцій і поширення дезінформації? Які виклики постають перед українцями під час війни, коли маніпулятивний контент створюється з метою дестабілізації суспільства? Як можна виявити загрозу в постах та відео, які на перший погляд здаються безневинними, але насправді мають маніпулятивний характер? Про ці питання обговорювали ведучі подкасту "Медіуми" Наталя Соколенко та Вадим Міський з Оксаною Полулях, фактчекеркою проєкту StopFake.org.

А також про те, як фейкові сторінки у соцмережах стають інструментом для збору аудиторії, яка згодом піддається впливу пропаганди та чому технології генеративного ШІ вже стали частиною сучасного інформаційного простору.

Підписатися на подкаст "Медіуми" можна на Apple Podcasts, Spotify, SoundCloud, MEGOGO Audio, NV Подкасти, YouTube Music, YouTube та інших подкастингових платформах.

00:00 "Ми стаємо свідками переважання контенту, генерованого штучним інтелектом, у соціальних мережах."

06:27 "Перед початком війни ми не мали справи з зображеннями або відео, створеними штучним інтелектом, а тепер стикаємося з таким контентом щодня."

08:10 "Штучний інтелект може виявитися як допоміжним, так і загрозливим."

12:10 "Блогери, які виступають проти вакцинації, не прямо розповсюджують російську дезінформацію, але все ж поширюють маніпулятивні дані."

13:49 "Нейромережі найефективніше справляються з малюванням людських облич. Їхня база даних формується з величезних колекцій зображень людей."

16:45 Технології продовжують еволюціонувати. Відрізнити зображення, створені штучним інтелектом, стає все більш складним завданням.;

18:30 "Приділяйте увагу дрібницям, адже саме вони можуть зрадити згенеровані зображення."

20:30 "Детектори штучного інтелекту не завжди є надійними. Вони можуть виступати лише як додатковий засіб."

24:22 "Вперше українці масово зіткнулися з дипфейками у відео в березні 2022 року."

27:44 "Незабаром на державному рівні виникне необхідність у регулюванні застосування штучного інтелекту."

29:32 "Ми стаємо свідками заповнення інформаційного простору зображеннями, створеними штучним інтелектом — це стирає межі реальності."

"Ми зауважуємо значне збільшення контенту, генерованого штучним інтелектом, у соціальних мережах."

Вадим Міський: Давайте обговоримо концепцію фальшивої реальності — яким чином і з якою метою штучний інтелект, а також контент, створений на його основі, можуть впливати на наші емоційні переживання.

Розпочну з того, що штучний інтелект став незамінним помічником у нашому житті. Лише два роки тому ми не мали такої різноманітності генеративних моделей, які стали доступними для широкої аудиторії. Сьогодні ці технології здатні допомагати з написанням текстів, створенням відео, обробкою зображень та виконанням розрахунків, що дозволяє просунутим користувачам інтернету ефективно вирішувати безліч завдань. Штучний інтелект може виступати в ролі наставника в навчанні, помічника на роботі, пояснювати складні теми, підсумовувати великі обсяги інформації, генерувати креативні ідеї, бути партнером у реалізації проєктів або навіть стати джерелом розваг. Наприклад, ви можете зіграти з ним у гру. І все це доступно цілодобово, що робить задоволення потреб простим і навіть ігровим. Це те, чого користувачі очікують від сучасних сервісів, і цей тренд, без сумніву, буде актуальним як в Україні, так і в усьому світі. Ми вже не можемо повернутися до епохи до появи штучного інтелекту, тому важливо навчитися співіснувати з цими технологіями. Ті, хто вміє їх використовувати, отримують суттєві конкурентні переваги. Проте це також створює нові виклики.

Зокрема, люди, які не можуть розпізнати інформацію, створену штучним інтелектом, ризикують стати жертвами маніпуляцій чи обману. Існує значна кількість осіб, які поки що не мають можливості ефективно протистояти цій проблемі.

Ось, наприклад, дослідження, проведене в Чикагському університеті, яке Оксана наводить у одному з своїх матеріалів. У цьому дослідженні зазначається, що лише 60% користувачів Інтернету здатні визначити, чи було зображення створено за допомогою штучного інтелекту. Вчені запропонували учасникам порівняти два зображення, і, як результат, лише 60% з них виявилися здатними правильно ідентифікувати згенероване зображення.

Наталка Соколенко: Якщо бути відвертою, я вражена. 60% людей вважають, що здатні це розпізнати. Ти справді в це віриш?

Вадим Міський: Я маю враження, що, можливо, вони зверталися до більш освічених людей. Було б цікаво провести подібне дослідження в Україні. Вважаю, що варто взяти це на озброєння. Проте існують також інші дослідження, які безпосередньо стосуються України, і їх результати виявляються дуже різноманітними.

Згідно з дослідженням Kantar Ukraine, проведеним у лютому 2024 року, 79% українців мають знання про штучний інтелект. Проте лише 42% респондентів впевнені у своїх здібностях розпізнавати контент, створений за допомогою цієї технології. Ці цифри виглядають досить оптимістично, враховуючи, що "Детектор медіа" в той же період провів своє дослідження з менш позитивними результатами. Ми запитували людей: "Чи вважаєте ви, що штучний інтелект може бути використаний для поширення дезінформації та створення неправдивого контенту?" Відповіді виявилися такими: 46% респондентів не змогли визначитися і обрали варіант "Важко сказати". 27% підтвердили, що чули про випадки поширення неправди, згенерованої штучним інтелектом, але не знають, як це розпізнати. 15% респондентів заперечують наявність загроз з боку штучного інтелекту, стверджуючи, що це не викликає у них жодних побоювань. Лише 12% українців зазначили, що усвідомлюють можливість використання штучного інтелекту для маніпуляцій, але при цьому регулярно перевіряють інформацію та мають навички роботи з цією технологією. Отже, виявляється, що лише 12% населення володіють такими навичками, тоді як 88% або не можуть зорієнтуватися у ситуації, або вважають штучний інтелект безпечним, або ж зізнаються у нездатності ідентифікувати маніпулятивний контент.

Власне, хотілося б, відштовхнувшись від цих показників, які ми маємо в Україні, розібратися в тому, чому штучний інтелект -- ті зображення, відео, тексти, які він генерує -- настільки допомагає створювати маніпулятивний контент і чому так важко його відрізнити.

Оксана Полулях: Безумовно, ця статистика викликає занепокоєння, особливо враховуючи постійний розвиток штучного інтелекту. За останні три роки ми регулярно стикаємося з контентом, що генерується за допомогою штучного інтелекту, і спостерігаємо за тим, як він стає все більш досконалим, що ускладнює його виявлення та спростування.

Проте ця тенденція -- це загальносвітове явище, а не лише проблема України. Ми спостерігаємо засилля контенту, створеного штучним інтелектом, у соціальних мережах. Але коли це відбувається в умовах війни, ситуація набуває загрозливого характеру. Йдеться не лише про інформаційну грамотність чи про те, що ви можете стати жертвами шахраїв.

"До війни ми не зустрічалися з зображеннями чи відео, згенерованими штучним інтелектом, зараз ми бачимо такий контент щодня"

Оксана Полулях: Ви можете також стати жертвою впливу релігійних структур, які нерідко застосовують відео та інші матеріали, створені за допомогою штучного інтелекту.

Наталка Соколенко: Правда?

Оксана Полулях: Нещодавно Інститут масової інформації опублікував дослідження, присвячене цій темі. Вони вивчали, яким чином релігійні організації використовують відеозаписи, створені за допомогою штучного інтелекту, щоб впливати на людей. У цих відео фігурували нібито українські військові, і таким чином організації намагалися залучити нових прихильників, закликаючи їх переходити за наданими посиланнями.

Вадим Міський: Так, "ці чотири брати, що служать на передовій". Всі вони мають схожі риси, мов четвірнята. "Постав сердечко і помолися Богові". Ми знаємо, що такі ситуації дійсно мають місце.

Оксана Полулях: На мою думку, у цій статистиці викликає занепокоєння не лише те, що багато людей не можуть відрізнити реальні зображення від тих, що створені штучним інтелектом. Також тривожить, що приблизно 20% населення взагалі не має уявлення про те, що таке штучний інтелект. Очевидно, вони навіть не усвідомлюють ті загрози, з якими можуть зіткнутися, користуючись соціальними мережами.

Наприклад, до початку війни ми, як фактчекери, рідко натрапляли на зображення або відео, створені за допомогою штучного інтелекту. Наразі ж ми стикаємося з таким контентом щоденно або кілька разів на тиждень. Регулярно зустрічаючи подібні матеріали, ми помічаємо, як їх активно використовують у пропагандистських цілях. Це викликає у нас особливе занепокоєння як у українців, особливо в умовах війни, коли інформаційний простір перевантажений, а контенту надзвичайно багато. У таких обставинах людині легко заплутатися: де знаходиться істина, а де фальш.

"Штучний інтелект має потенціал бути як допоміжним, так і загрозливим."

Наталка Соколенко: Якщо розглянути існування звичайної людини, що живе в умовах, скажімо, звичних, а не в екстремальних ситуаціях. Але ж у сучасному світі існує чимало викликів — чи може у цьому контексті штучний інтелект бути небезпечним? Які саме виклики можуть виникнути?

Оксана Полулях: Насправді, штучний інтелект може бути як корисним, так і небезпечним. Для нас, фактчекерів, він є цінним інструментом, адже ми використовуємо різноманітні технології, засновані на штучному інтелекті, для перевірки згенерованих зображень і відео, а також для перекладу та аналізу текстів. Однак для звичайних користувачів соціальних мереж ситуація виявляється більш складною. Практично кожен день вони стикаються з контентом, який був створений за допомогою штучного інтелекту, і це стосується не лише відео та фотографій, а й текстів.

Також активно використовують системи, де боти розсилають і масштабують різні тези за допомогою однотипних коментарів. Це теж працює на основі штучного інтелекту. Звичайна людина, яка споживає такий контент некритично, може, наприклад, стати жертвою шахраїв. Існують дослідження в Сполучених Штатах, які показують, що у них поширюють схожий контент, як і в нас в Україні. Але адаптований до їхніх умов. Наприклад, дописи типу: "Привітайте дідуся з днем народження, його сьогодні ніхто не привітав".

Наталка Соколенко: Чи є в США щось подібне?

Оксана Полулях: Так, або, наприклад, дописи з зображеннями людей з інвалідністю: "Будь ласка, підтримайте, мені потрібна ваша допомога чи привітання". Ці дослідження показують, що часто сторінки, які поширюють такий контент, використовують його для збільшення охоплення, збору лайків тощо. Потім ці сторінки можуть бути перейменовані й змінити тематику, почавши поширювати зовсім інший контент, зокрема політичний.

Ця стратегія має загальне значення не лише для США, а й для багатьох інших країн, включаючи Україну. У нашій державі більшість такого контенту пов'язана з війною. Наприклад, ми часто натрапляємо на зображення військових, які просять про допомогу, або пости на кшталт "дві сестри, що служать у Збройних силах України", з проханням: "Будь ласка, привітайте їх".

Вадим Міський: "Отже, ця пара сьогодні одружилася, і ніхто не привітав їх, вірно?"

Оксана Полулях: Здається, що на перший погляд немає нічого небезпечного в тому, щоб залишити привітання чи коментар. Але насправді стратегія залишається незмінною. Сторінки, які поширюють подібний контент, здобувають все більше уваги та розширюють свою аудиторію. В подальшому їхня доля може бути дуже різною. Часто можна зауважити, як такі сторінки, які постійно публікують схожі матеріали, згодом змінюють свої назви, починають викладати інший контент і, врешті-решт, можуть використовуватися для пропаганди. Центр протидії дезінформації при РНБО попереджає про те, що таким чином російська сторона може залучати людей, які легше піддаються впливу. Вони створюють такі платформи, щоб згодом реалізувати свої цілі.

"Блогери-антивакцинатори відкрито не поширюють російську дезінформацію, проте вкидають маніпулятивну інформацію"

Вадим Міський: Мені спало на думку, що цей процес схожий на діяльність антивакцинаторських платформ. Хоча в той час штучний інтелект ще не здобув такої популярності, принципи залишалися подібними. На базі певної чутливої теми формувалася спільнота, яка активно генерувала контент, щоб залучити людей, викликати емоції та спонукати до обговорення. У подальшому ці ресурси почали використовуватися для цілей, що не мали жодного стосунку до початкової теми: для пропаганди або шахрайських схем. Часто їх перейменовували, і так те, що розпочиналося як антивакцинаторська кампанія, закінчувалося зовсім іншим напрямком.

Оксана Полулях: Нещодавно я відвідала Північну Македонію в рамках бізнес-подорожі, і ми обмінювалися досвідом, виявивши, що у них спостерігається подібна ситуація. Антивакцинатори там також активно поширюють проросійську дезінформацію. Стратегія залишається незмінною: вони залучають вразливі верстви населення, які вірять у різноманітні конспірологічні теорії. З часом, коли питання вакцинації проти COVID-19 втратило свою актуальність, ці спільноти трансформувалися на платформи, що розповсюджують російську пропаганду.

Аналогічну ситуацію ми спостерігаємо і в Україні. Численні антивакцинаторські блогери, хоча й не поширюють відкрито російську дезінформацію, все ж займаються маніпуляцією інформації. Наприклад, вони заперечують мобілізацію, поширюючи відео, вирвані з контексту, що стосуються мобілізації, корупційних схем тощо. У такий спосіб вони сприяють реалізації пропагандистських наративів та цілей Кремля.

"У нейромереж найкраще виходить малювати обличчя людей. Їхня база даних складається з величезних масивів зображень людей"

Вадим Міський: Мені хотілося б глибше зануритися в особливості функціонування штучного інтелекту та спробувати розкрити його "чорний ящик" для наших слухачів. Я з великим інтересом спостерігав за тим, як штучний інтелект застосовується у створенні аудіовізуального контенту Лексом Фрідманом, який нещодавно провів інтерв'ю з Зеленським. Ми мали можливість переглянути це інтерв'ю, в якому постійно відбувалося перемикання між трьома мовами: українською, англійською та російською.

Наталка Соколенко: І з ненормативною лексикою. Її також потрібно було адаптувати, але, здається, Фрідман не був у захваті від того, як це зробила жива особа.

Вадим Міський зазначив, що найзахопливіші події трапилися в кінці, коли було представлено готовий продукт. У ньому містилося три окремі аудіотреки: російською, англійською та українською. Коли Зеленський говорить українською, його голос звучить рідною мовою, а в тих епізодах, де він висловлюється англійською, його слова дублюються українською. У реалізації цього проекту значну роль відіграла програма ElevenLabs.

До речі, ми теж працювали з цією програмою, коли створювали телеурок для українців в ефірі телемарафону. Ми тоді зробили дипфейк, де Путін оголошує капітуляцію, щоб продемонструвати, наскільки ця технологія проста у використанні. Зокрема, для генерації голосу ми використали саме ElevenLabs і показали українцям в ефірі, що це доволі проста річ. Зробити таке неважко, тому варто бути уважним до кожного шматочка контенту, який ви бачите. Але якщо повернутися до того, що ми побачили в інтерв'ю Зеленського у Фрідмана, то стає зрозуміло: ці технології вже дуже близько до нас. Вони стали частиною професійного продакшну й активно використовуються. Як штучному інтелекту вдається настільки точно імітувати роботу людини й бути настільки схожим на неї?

Оксана Полулях: Відомо, що існує безліч нейромереж, які виконують різні завдання. Якщо зосередитися на генерації зображень, українські користувачі часто обирають такі сервіси, як Midjourney, DALL-E або Bing. Насправді, існує величезна кількість таких платформ, і вони відрізняються за складністю та функціоналом. Загалом, принцип їх роботи полягає в тому, що ви надаєте детальний опис бажаного зображення, а нейромережа створює його для вас. Багато користувачів, напевно, помітили, що ці системи найкраще справляються з малюванням людських облич. Це пояснюється тим, що їхні бази даних містять величезні колекції зображень саме людей. Таким чином, нейромережі досягли найбільших успіхів у створенні портретів.

Вадим Міський: Дивує, що такі прості частини тіла, як руки, часто зображуються з невірною кількістю пальців, тоді як обличчя – це зовсім інша історія. Навіть для художників малювання обличчя завжди є більш складним завданням. Це вимагає значно більше часу та глибшого освоєння – пропорції, деталі...

Наталка Соколенко: Руки теж малювати непросто, але ти правильно зауважив: обличчя все ж складніше, адже там є очі, рот... І виходить це краще, ніж із руками.

Оксана Полулях: Верно.

Технології продовжують еволюціонувати. Відрізнити зображення, створені штучним інтелектом, стає все більш складним завданням.

Оксана Полулях: Якщо пригадати ті зображення, на яких нібито військові просять про підтримку чи вітання, то можна звернути увагу на те, що їхні обличчя виглядають досить детально. Проте, інша частина, зокрема військова форма, виглядає досить загально. Ми спостерігаємо щось, що нагадує військовий одяг, якийсь камуфляж, але якщо уважно придивитися, виникають запитання: який саме це камуфляж і чи він взагалі існує? Крім того, часто можна помітити, що замість справжньої військової форми це може бути щось на кшталт комбінезона, тобто єдиного цілого вбрання.

Або, наприклад, ті самі патчі -- їхній розмір буває невідповідним реальному. Або ж різні наліпки, які показують, до якого підрозділу належить військовий. Якщо ми говоримо про зображення, згенеровані штучним інтелектом, то ці елементи виглядають дуже умовно. Ви або взагалі нічого не роздивитесь, або побачите, що вони розпливаються і виглядають дуже спрощено.

Схожа ситуація спостерігається і з текстами: штучний інтелект часто опускає літери, внаслідок чого текст виглядає спотвореним або незавершеним. Справа в тому, що нейронна мережа фокусується на обличчях, але продовжує помилятися в дрібницях. Проте ми вже можемо спостерігати позитивні зміни. Наприклад, якщо півроку тому проблема з кількістю пальців була досить поширеною — шість пальців на зображеннях виглядали звично, — то нині таких випадків значно поменшало.

Вадим Міський: Отже, штучний інтелект розвивається?

Оксана Полулях: Так, технології прогресують, і внаслідок цього стає все важче відрізняти штучно створені зображення.

"Звертайте увагу на деталі, адже саме вони можуть видавати згенеровані зображення."

Наталка Соколенко: Мені хотілося задати важливе питання: "Які дії вжити, шановна редакціє?"

Оксана Полулях: По-перше, ця технологія досить активно розвивається і нам стає все складніше її розпізнавати. Що може зробити простий користувач мережі? Уважно дивіться на деталі, адже саме вони часто видають згенеровані зображення. Звертайте увагу на те, як зображені кінцівки: чи правильна кількість пальців, рук і так далі.

Часто виникають труднощі з освітленням — можуть з'являтися помилки у відтворенні тіней, які падають невірно, або ж деякі частини тіла освітлені незрозумілим чином. Адже ми знаємо, що наше сонце єдине і світло від нього йде тільки з одного напрямку.

Зверніть увагу на деталі одягу. Наприклад, прикраси на жінках можуть дивно висіти на вухах або "плавати" в повітрі. Годинники можуть некоректно прилягати до шкіри. Зверніть увагу на одяг, він також може неправильно прилягати. Або шоломи на головах можуть виглядати так, ніби мають деталі, яких насправді не існує.

Не забувайте про фон. Він може бути дуже умовним: розмитим, з нечіткими елементами. Штучний інтелект здатен "полегшити" процес, просто копіюючи пікселі. Наприклад, цегляна стіна на задньому плані може виглядати абсолютно ідентично по всій своїй площі.

"Детектори штучного інтелекту не завжди демонструють свою ефективність. Вони можуть служити лише як додатковий інструмент."

Вадим Міський: Важливо зазначити, що те, що один штучний інтелект генерує, може бути виявлено іншим. Це стосується не лише візуальних матеріалів, але й текстів. На сьогоднішній день вже існують спеціалізовані детектори, здатні виявляти тексти, створені штучним інтелектом. Наприклад, коли постає завдання проаналізувати резюме кандидатів, мотиваційні листи, надіслані нам тексти, або навіть дипломні роботи, штучний інтелект може допомогти виявити, чи було це створено іншим штучним інтелектом. Яким чином це відбувається?

Оксана Полулях: Проте, на жаль, я вас, напевно, засмучу, оскільки цей інструмент існує, але він не настільки дієвий, як би нам хотілося. І він не може з такою стовідсотковою вірогідністю сказати, чи це зображення дійсно було згенероване штучним інтелектом чи ні. Звісно, існує багато таких детекторів, і якщо говорити про зображення, вони здатні з певною вірогідністю сказати, чи були ці зображення згенеровані штучним інтелектом. Деякі з цих детекторів навіть можуть визначити нейромережу, за допомогою якої було створено ці зображення.

Проте, на жаль, ці детектори не завжди працюють. Дуже часто, якщо зображення було завантажене, а потім знову вивантажене, воно втрачає свою якість. Тому ці детектори погано працюють із зображеннями низької якості.

Ще один важливий момент: якщо ви натрапили на зображення і переконані, що воно створене за допомогою штучного інтелекту, варто врахувати, що різні детектори можуть дати неоднозначні результати. Ці інструменти можуть бути корисними, але їх ефективність значно зростає в поєднанні з вашими власними спостереженнями. Необхідно самостійно вивчити зображення, яке вас цікавить, а також скористатися детекторами. Крім того, вам слід провести додаткові дослідження: визначити, хто поширює це зображення та на якій платформі воно з’явилося. Наприклад, якщо мова йде про Facebook, можна перевірити прозорість сторінки, дізнатися, хто є модераторами, з яких країн вони походять, чи змінювалася назва сторінки, коли вона була створена, та чи має вона активні рекламні кампанії. Ця інформація може виявитися надзвичайно корисною.

Якщо ж ці зображення поширюються через соціальні мережі, які дозволяють викачати метадані, ми можемо перевірити метадані -- і це дасть нам певну інформацію. У Facebook, наприклад, ми не можемо отримати метадані зі збереженої фотографії.

Що стосується відео, ситуація залишається подібною. Детектори можуть слугувати додатковим інструментом для виявлення, чи було відео створене за допомогою штучного інтелекту, а також яка технологія була застосована. Наприклад, на даний момент російські користувачі активно використовують технології маскування, які накладають маски на обличчя акторів, створюючи фальшивий контент. Ці детектори також здатні виявляти, чи було аудіо згенеровано штучним інтелектом. Проте, як і раніше, часто виникають помилкові сповіщення, тому для досягнення більшої точності варто використовувати різні методи, адже лише в комплексі вони можуть забезпечити правильний результат.

Та сама ситуація спостерігається й з текстами. На жаль, багато з тих детекторів, які ми застосовуємо для їх оцінки, мають схильність до помилок. Однак я впевнений, що з часом ці проблеми будуть усунуті.

"Вперше українці на великій шкалі зіткнулися з відео, створеними за допомогою технології дипфейк, у березні 2022 року."

Оксана Полулях: Я повернуся до теми відео. Дозвольте навести два приклади. Вперше українці масово зіткнулися із явищем дипфейк-відео в березні 2022 року, коли з'явилося відео з Володимиром Зеленським. Пізніше з'явилися подібні відеоматеріали, але низької якості, з Генералом Залужним та Сирським. Звичайний користувач інтернету може помітити, що щось не так: міміка виглядає неприродно, інтонації мови не відповідають реальності тощо. Ми здатні зрозуміти, що існує певна аномалія, і запідозрити, що це відео могло бути створене за допомогою штучного інтелекту.

Однак, приблизно рік тому російська пропаганда розпочала кампанію з випуску серії відео. Центральною фігурою в цих матеріалах став нібито український військовий на ім'я Воха, якому приписували синдром Дауна. У відеороликах демонструвалося, як його, за словами авторів, переслідують і принижують інші солдати. Ці відео отримали значний розголос не тільки в російськомовному та українському просторах, але й активно поширювалися в англомовних колах. Вони вражали емоційним зарядом і викликали жваві обговорення, адже головним героєм був чоловік з синдромом Дауна.

Вадим Міський: Вони, до речі, були дуже реалістичні, що, чесно кажучи, навіть з окремих відео у мене складалося враження, що це просто постановне відео, а не створене штучним інтелектом. Тобто у вас є впевненість, що це був саме штучний інтелект?

Оксана Полулях: Телебачення Торонто проробило дуже велику роботу. Вони аналізували ці відео й довели, що вони були створені за допомогою масок. Тобто використовувався актор, на якого потім накладалася ця маска. І тут найцікавіше, що вони пішли далі. Адже, напевно, у когось могли виникнути сумніви, оскільки цей дипфейк був дуже якісним, відео мало дуже високу якість. Вони почали аналізувати, звідки поширювалися ці відео і хто ж є їхнім автором. Це якраз дуже цікаво, оскільки їм вдалося виявити мережу, яка діє на окупованій території Луганщини. Усі автори працюють у тамтешній так званій "народній міліції". Тобто вони виявили конкретних людей, які займалися створенням і поширенням цих відеороликів у групах телеграм-каналів.

Цей випадок чітко ілюструє, наскільки важливо використовувати різні методи перевірки при аналізі такого контенту. Лише сказати: "Ось детектор штучного інтелекту виявив, що це відео, ймовірно, створене нейромережею" – недостатньо, оскільки ці детектори можуть давати неточні результати.

Вадим Міський: Варто зазначити, що в цьому жанрі також працює "Пан Роман". Це персонаж, створений для TikTok-акаунту. Блогер Роман Чихарівський втілив цей образ, і це дійсно цікаво. Він не ховає своє справжнє обличчя, дає інтерв'ю і відкрито зізнається, що це лише вигадка — комедійний персонаж, який існує в інтернет-просторі та ділиться вигаданими оповідями. Проте схожий підхід можна реалізувати й без розкриття особистості, яка стоїть за цим процесом.

"Незабаром виникне необхідність національного регулювання застосування штучного інтелекту."

Наталка Соколенко: Яким ви бачите майбутнє? Чи можемо очікувати, що з'явиться потреба в національних та міжнародних законодавчих актах, які будуть притягувати до відповідальності тих, хто експлуатує штучний інтелект для введення людей в оману?

Оксана Полулях: Насправді, великі технологічні компанії, такі як Google і Meta, вже активно розглядають способи регулювання штучного інтелекту. Це питання стає все більш актуальним, оскільки штучний інтелект може нести численні загрози — від шахрайства до ризиків для національної безпеки. Дослідження свідчать про те, що країни, як-от Росія, Іран і Китай, дедалі частіше інтегрують різноманітні технології штучного інтелекту у свої інформаційні стратегії.

В даний час триває активне обговорення необхідності маркування контенту, що містить елементи, створені за допомогою штучного інтелекту. Наприклад, відео або зображення повинні бути позначені спеціальним значком, який вказує на те, що цей контент був згенерований штучним інтелектом. Я вважаю, що на національному рівні рано чи пізно буде потрібно встановити регуляції в цій сфері, оскільки ми вже спостерігаємо, які небезпеки може нести безконтрольне використання штучного інтелекту. Особливо це актуально для України в умовах війни, коли Росія активно використовує ці технології у своїх кампаніях. Вважаю, що першими кроками в цьому напрямку повинні стати дії таких компаній, як Google та Meta, щоб забезпечити більш ефективне регулювання ситуації.

"Ми стаємо свідками перенасичення інформаційного простору зображеннями, створеними штучним інтелектом, що призводить до розмивання меж між реальністю та віртуальністю."

Вадим Міський: Що, на вашу думку, варто враховувати журналістові, коли він використовує штучний інтелект у своїй роботі? Чи є щось, що точно повинно бути червоною лінією? Як нам не перетворитися на людей, які використовують цей добрий інструмент у злочинний спосіб?

Оксана Полулях: На мою думку, передусім слід зосередитися на можливих наслідках. У цьому зв'язку варто згадати випадок минулого року, коли акаунт Верховної Ради опублікував зображення, створене штучним інтелектом, після чергової атаки Росії на Дніпро. На картині зображувався хлопчик, який, за повідомленнями, втратив свою сім'ю внаслідок цього удару. Це, на мою думку, є яскравим свідченням того, що використання штучного інтелекту вимагає великої відповідальності.

Цілком ймовірно, що зображення або відео, створене за допомогою штучного інтелекту, могло б стати вдалим доповненням до вашого повідомлення. Проте варто задуматися: чи не призведе використання таких інструментів — згенерованих зображень — до більш негативних наслідків у порівнянні з ілюстрацією публікації справжніми фотографіями?

Неможливо заперечити, що інтеграція інструментів на базі штучного інтелекту стає невід'ємною частиною нашого повсякденного життя та професійної діяльності. Як фактчекери, ми також активно використовуємо різноманітні технології. Проте важливо підходити до їх застосування з усвідомленою відповідальністю. Це стосується не лише журналістів, але й звичайних користувачів Інтернету. Коли ми створюємо або розповсюджуємо такий контент, необхідно завжди враховувати можливі наслідки, які можуть виникнути в результаті.

Наталка Соколенко: У мене є пропозиція: до Кодексу журналістської етики треба додати пункт, який регулює використання штучного інтелекту журналістською спільнотою. Мені здається, час настав.

Вадим Міський: Так, є ж рекомендації, які ще восени 2023 року дала Комісія журналістської етики. Але, вочевидь, ми вже підходимо до того моменту, коли треба включати це і до самого Кодексу, бо це досить основоположна історія.

Оксана Полулях: Так, мені здається, хоча б найпростіше, що може зробити журналіст, якщо він використовує згенеровані штучним інтелектом зображення чи відео -- промаркувати їх і вказати, що фото було згенероване штучним інтелектом. І все ж таки варто надавати перевагу реальним фото і відео, якщо вони доступні. Адже те, що ми зараз спостерігаємо -- насичення інформаційного простору зображеннями, згенерованими штучним інтелектом, -- розмиває реальність і зрештою її спотворює.

Нагадаємо, в попередніх випусках подкасту "Медіуми" говорили з Катериною Городничою про те, як клікбейт став бізнесом у глобальному медіапросторі, Павлом Бєлоусовим про те, чому медіаграмотність неможлива без цифрової грамотності, Оксаною Волошенюк про те, як українські діти в школі опановують навички критичного мислення, Денисом Зеленовим про роботу соцмереж "24 каналу" і штучний інтелект, Мариною Кафтан про те, чому критичне мислення -- головна зброя проти інформаційних атак, Лідією Смолою про те, як алгоритми соцмереж підштовхують до емоційних рішень і що робить нас легкою мішенню для інформаційних атак, Ольгою Кравченко про конференцію "Стійкі разом: розвиток медіаграмотності в Україні", Дмитром Литвином про "Укрінформ", "УП", телемарафон та "офреки" для журналістів, Крістіною Гаврилюк із Мінцифри про те, чи здатні DMA і DSA змінити правила гри на європейському ринку цифрових послуг, Олександром Педаном про співпрацю з Суспільним, новий проєкт замість "УніверCheck" та інші ідеї Pedan buro, Катериною Котвіцькою з Megogo Audio про аналіз поточної ситуації та трендів у сфері дистрибуції аудіоконтенту онлайн, Галою Котовою з Viber про те, як досвід роботи під час пандемії допоміг команді Rakuten Viber зростати після початку широкомасштабного вторгнення.

The "Mediums" podcast, produced by Detector Media, was created in collaboration with UNESCO and benefitted from support provided by Japan. The creators are accountable for the choices made in the selection and presentation of the information featured in this work. The opinions shared are exclusively those of the authors and may not align with the views of UNESCO or Japan.

Інші публікації

Популярное

В тренде